Для просмотра этой видеозаписи необходимо авторизоваться

АвторизацияKubernetes

От: admin Видео: 73

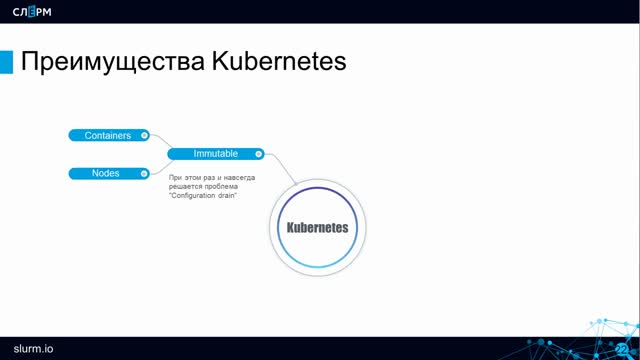

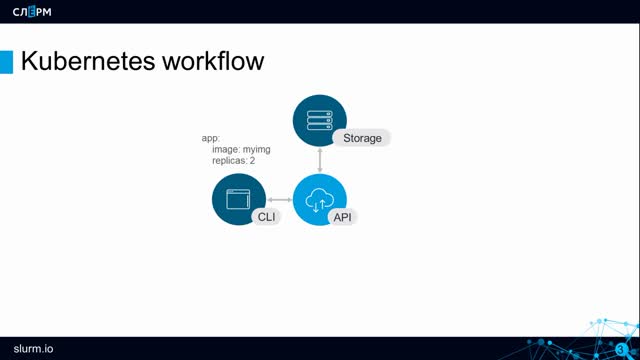

k8s Обзор Концепции Кубернетис

От: admin

8:59

От: admin

3:54

От: admin

11:22

От: admin

15:12

k8s Проверка работоспособности

От: admin

10:08

От: admin

11:33

k8s Хранение конфигураций Configmap

От: admin

11:08

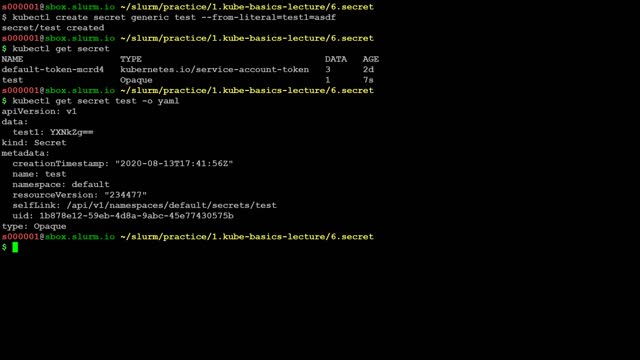

k8s Хранение конфигураций Secret

От: admin

6:25

От: admin

7:13

От: admin

3:39

От: admin

19:04

От: admin

10:26

От: admin

0:26

От: admin

2:14

От: admin

4:55

От: admin

3:16

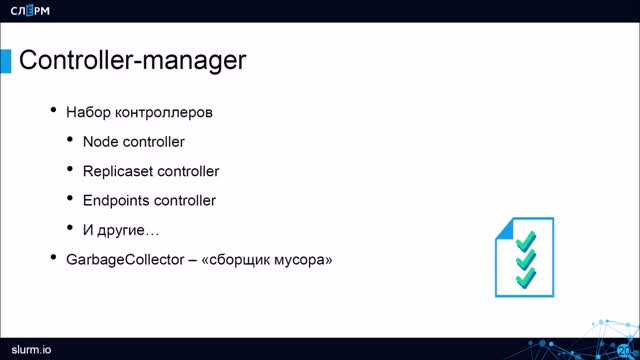

k8s Компоненты controller-manager

От: admin

3:32

От: admin

8:09

От: admin

3:30

От: admin

3:10

От: admin

9:07

От: admin

5:55

От: admin

5:31

От: admin

6:52

От: admin

6:58

От: admin

3:30

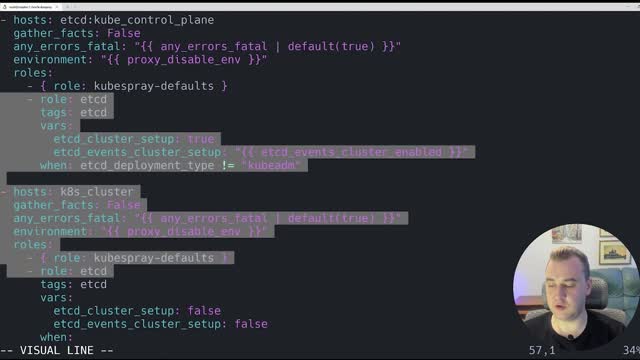

k8s kubespray Устройство playbook

От: admin

3:10

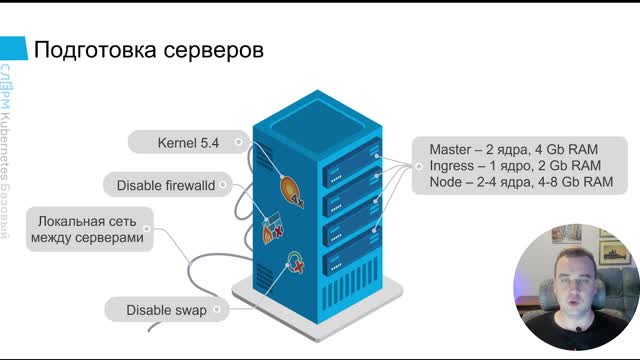

k8s kubespray Подготовка серверов

От: admin

4:01

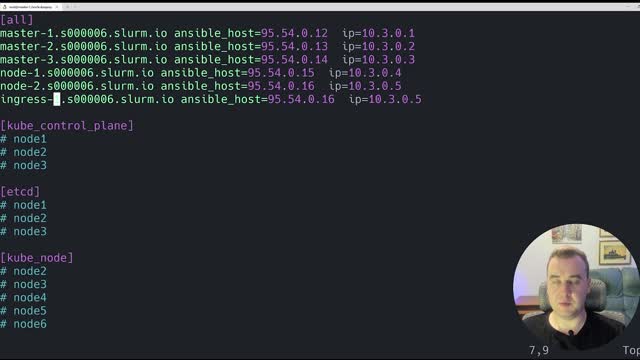

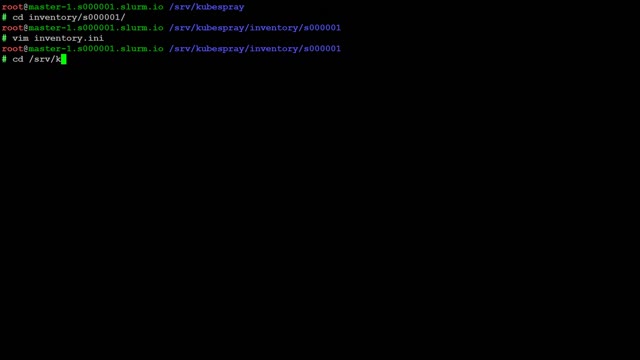

k8s kubespray Заполняем инвентарь

От: admin

9:44

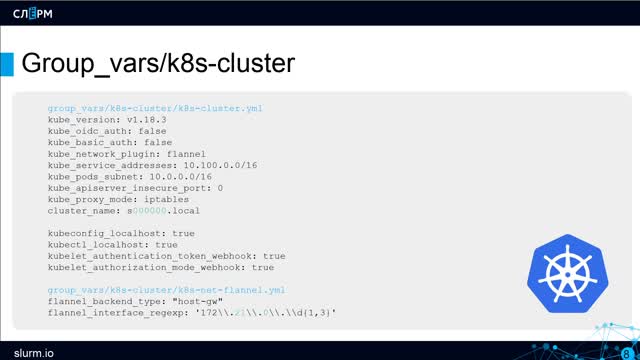

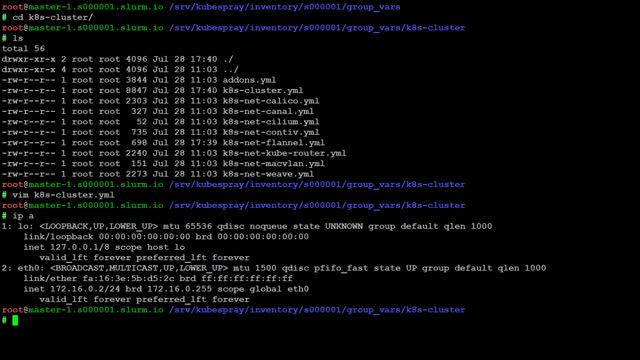

k8s kubespray настройка переменных

От: admin

8:35

k8s kubespray настройка переменных2

От: admin

1:04

От: admin

2:17

От: admin

5:29

От: admin

2:52

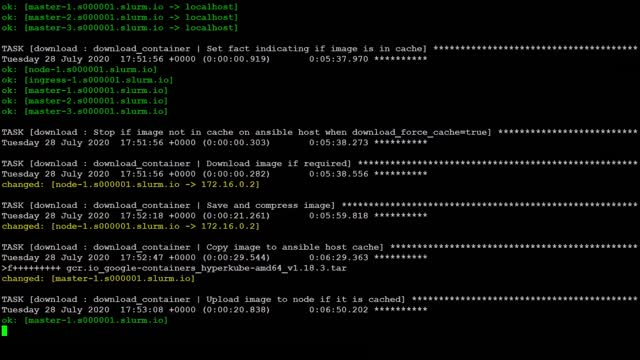

k8s kubespray Обновление кластера

От: admin

6:18

k8s kubespray Обновление кластера2

От: admin

7:13

От: admin

0:45

От: admin

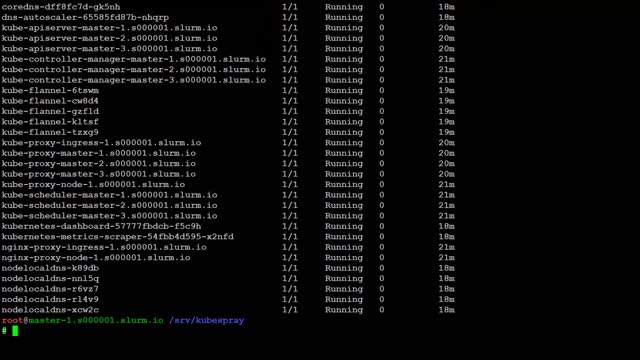

16:16

От: admin

11:05

От: admin

6:52

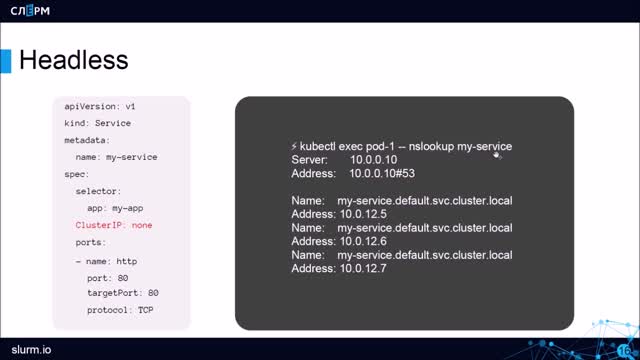

k8s Абстракции Headless Service

От: admin

5:23

От: admin

9:37

От: admin

4:29

От: admin

11:25

k8s Публикация сервисов Введение

От: admin

0:26

От: admin

3:54

От: admin

2:39

От: admin

1:45

От: admin

2:27

От: admin

2:08

От: admin

7:05

От: admin

11:29

От: admin

1:56

От: admin

0:19

От: admin

4:56

От: admin

23:35

От: admin

18:48

От: admin

5:45

От: admin

8:11

От: admin

16:33

От: admin

14:48

От: admin

0:29

От: admin

10:31

От: admin

3:05

От: admin

3:19

От: admin

5:44

От: admin

2:53

От: admin

9:40

От: admin

12:47

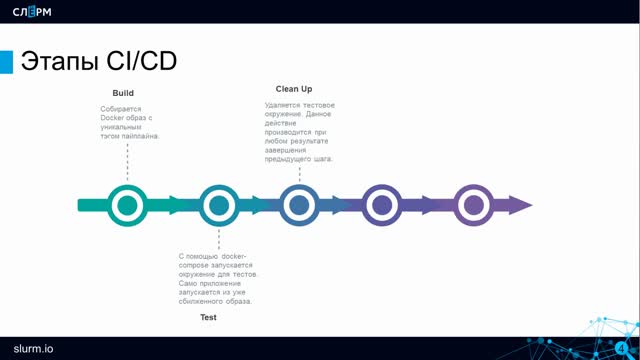

k8s CI/CD Обновление приложений

От: admin

3:43

Описание

Поделиться

Добавить в

Вам надо авторизоваться чтобы добавлять видеозаписи к спискам воспроизведения.

Комментарии (6)

Авторизуйтесь чтобы комментировать.

Advertisement

Установка Ceph CSI driver для подключения CephFS

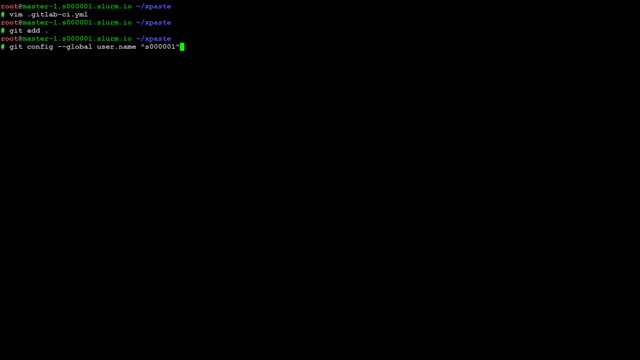

Все работы проводим под root'ом

Заходим на master-1 и клонируем репозиторий наш

cd ~

git clone https://edu-git.gpu.su/edu/Kubernetes

cd ~/kubernetes/practice/7.datastorage/cephfs/

Далее будем работать на двух серверах: node-1 и master-1 Все команды kubectl выполняются на master-1 Команды ceph и rbd выполняются на node-1

На серверах ingress-1, node-1 и node-2 развернут кластер ceph, более подробно установка рассмотрена в курсе по ceph.

На сервере node-1 настроен доступ в ceph с правами администратора.

Получаем файл с настройками chart'a

1) Заходим на master-1 и получаем переменные chart'a ceph-csi-cephfs

(ставить будем версию 2.1.2, потому что в версиях 3.x.x опять сломали изменение размера тома)

helm repo add ceph-csi https://ceph.github.io/csi-charts

helm inspect values ceph-csi/ceph-csi-cephfs --version 2.1.2 >cephfs.yml

Заполняем переменные в cephfs.yml

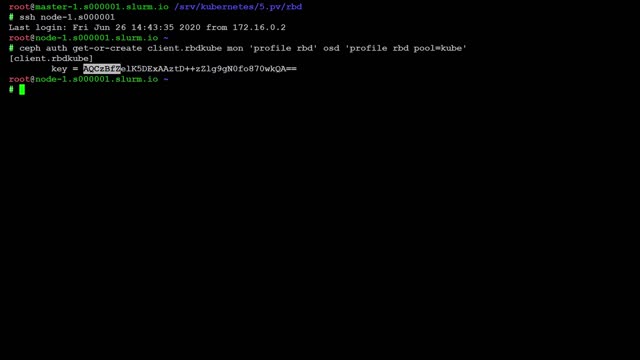

2) Выполняем на node-1, чтобы узнать необходимые параметры:

Получаем clusterID

ceph fsid

Получаем список мониторов кластера Ceph

ceph mon dump

3) Возвращаемся на master-1 и правим файл cephfs.yml

Заносим свои значение clusterID, и адреса мониторов, включаем создание политик PSP.

!! Внимание, адреса мониторов указываются в простой форме адреc:порт, потому что они передаются в модуль ядра для монтирования cephfs на узел. !! А модуль ядра еще не умеет работать с протоколом мониторов v2

Список изменений в файле cephfs.yml. Опции в разделах nodeplugin и provisioner уже есть в файле, их надо исправить так как показано ниже.

csiConfig:

- clusterID: "bcd0d202-fba8-4352-b25d-75c89258d5ab"

monitors:

- "172.X.X.5:6789"

- "172.X.X.6:6789"

- "172.X.X.7:6789"

nodeplugin:

podSecurityPolicy:

enabled: true

provisioner:

replicaCount: 1

podSecurityPolicy:

enabled: true

При необходимости можно свериться с файлом cephfs/cephfs-values-example.yml

Устанавливаем чарт

4) Запускаем на master-1

helm upgrade -i ceph-csi-cephfs ceph-csi/ceph-csi-cephfs -f cephfs.yml -n ceph-csi-cephfs --create-namespace --version 2.1.2

Создаем Secret и StorageClass

В документации указано, что provisioner'у CephFS необходимы права доступа администратора кластера. Но мы создадим отдельного пользователя fs, с более ограниченными правами

5) Создаем пользователя для cephfs

Возвращаемся на node-1

ceph auth get-or-create client.fs mon 'allow r' mgr 'allow rw' mds 'allow rws' osd 'allow rw pool=cephfs_data, allow rw pool=cephfs_metadata'

6) Посмотреть ключ доступа для пользователя fs

ceph auth get-key client.fs

вывод:

AQCO9NJbhYipKRAAMqZsnqqS/T8OYQX20xIa9A==

7) Заполняем манифест secret.yml

Выполняем на master-1

cd ~/slurm/practice/7.datastorage/cephfs/

vi secret.yaml

Заносим имя пользователя fs и значение ключа в

adminID: fs

adminKey: AQCO9NJbhYipKRAAMqZsnqqS/T8OYQX20xIa9A==

8) Создаем секрет

kubectl apply -f secret.yaml

9) Получаем id кластера ceph

Выполняем на node-1

ceph fsid

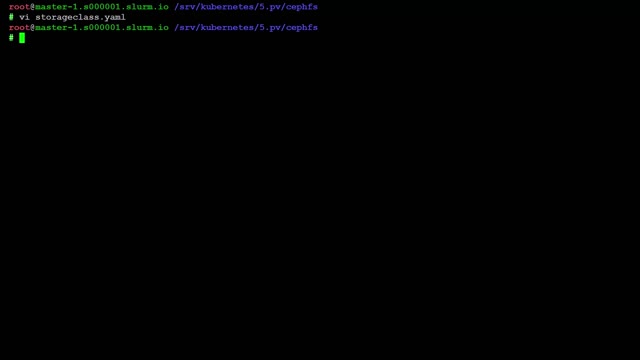

10) Заносим clusterid в storageclass.yaml

Выполняем на master-1

vi storageclass.yaml

clusterID: bcd0d202-fba8-4352-b25d-75c89258d5ab

11) Создаем storageclass

kubectl apply -f storageclass.yaml

Проверяем как работает

..6:6789:/ /mnt/cephfs ceph name=admin,secretfile=/etc/ceph/secret.key,noatime,_netdev 0 2">>/etc/fstab

12) Создаем pvc, и проверяем статус и наличие pv

kubectl apply -f pvc.yaml

kubectl get pvc

kubectl get pv

Проверяем создание каталога в cephfs

13) монтируем CephFS на node-1

Выполняем на node-1

Точка монтирования

mkdir -p /mnt/cephfs

Создаем файл с ключом администратора

ceph auth get-key client.admin >/etc/ceph/secret.key

Добавляем запись в /etc/fstab

!!! Изменяем ip адрес на адрес узла node-1

echo "172.

mount /mnt/cephfs

14) Идем в каталог /mnt/cephfs и смотрим что там есть

cd /mnt/cephfs

Проверка знаний:

Как называется pvc который создали на предыдущем шаге ?